Datenanalyse und Validierung in der Biomedizintechnik

Inhaltsverzeichnis

In der modernen Biomedizintechnik werden integrierte Mess- und Interpretationsketten zunehmend eingesetzt, welche Sensoren, Erfassungskanäle, Verarbeitungsalgorithmen sowie Bildrekonstruktionsalgorithmen in einem einzigen System vereinen. Die klinische Praxis verlagert sich zunehmend hin zu integrierten Mess- und Interpretationsketten, in denen Sensoren, Erfassungskanäle, Verarbeitungsalgorithmen, Bildgebungstechniken sowie die organisatorischen und regulatorischen Rahmenbedingungen der klinischen Technik einen kontinuierlichen Informationsfluss bilden. Im Mittelpunkt dieses Artikels steht die Konstruktion von Sensoren für medizinische Anwendungen, der Aufbau zuverlässiger biologischer Signalerfassungsketten sowie die Transformation von Bildern und Signalen in klinische Informationen. Zudem wird begründet, weshalb das Technologiemanagement sowie die Standardisierung im Krankenhausumfeld für die Sicherheit und Wirksamkeit der Therapie von entscheidender Bedeutung sind.

Sensoren

Biomedizinische Sensoren wandeln mechanische, elektrische, optische oder chemische Größen in eine elektrische Form um, die mit modernen Messgeräten kompatibel ist. Ihr gemeinsames Merkmal ist die Transduktion, d. h. die Umwandlung einer Energieform in eine andere, und die Aufgabe des Konstrukteurs besteht darin, Verzerrungen und Störungen an der Schnittstelle zwischen Physiologie und Elektronik zu minimieren. Die biomedizinische Sensorik lässt sich unterteilen in physikalische Sensorik (z. B. Druck, Durchfluss, Temperatur), elektrochemische Sensorik (z. B. pH, pO₂, pCO₂, Glukose), optische Sensorik (z. B. Pulsoximetrie, Immunosensoren) und Biopotentialelektroden für EEG-, EKG- oder EMG-Signale. Diese Klassen bilden die Grundlage für die Kapitel über Sensoren im Lehrbuch, in denen betont wird, dass eine effiziente Informationskette mit der richtigen Interaktion des Sensors mit Gewebe und Körperflüssigkeiten beginnt.

Biopotentialelektroden, die zur Aufzeichnung bioelektrischer Aktivitäten verwendet werden, führen die Transduktion an der Grenzfläche zwischen Metall und Elektrolyt durch. An dieser spezifischen Grenzfläche wird ein Halbzellenpotential registriert, dessen Potenzialhöhe sich nach dem eingesetzten Elektrodenmaterial sowie der Zusammensetzung der Lösung richtet. Die Stabilität und Reversibilität von Redoxreaktionen bestimmen Rauschen, Drift und Artefakte, sodass die Auswahl der Materialien (z. B. Ag/AgCl als Referenzelektroden) und die Kontrolle der ionischen Umgebung für die Zuverlässigkeit der Messung langsam veränderlicher und niederfrequenter biologischer Signale von entscheidender Bedeutung sind.

In der elektrochemischen Literatur werden diese Phänomene ausführlich beschrieben und in Sensor-Kompendien systematisch zusammengefasst. Für die Umsetzung in der klinischen Praxis sind spezifische Designanforderungen zu formulieren, darunter eine niedrige Kontaktimpedanz, die Minimierung der Polarisation, stabile Referenzen sowie eine reproduzierbare Geometrie und ein reproduzierbarer Druck.

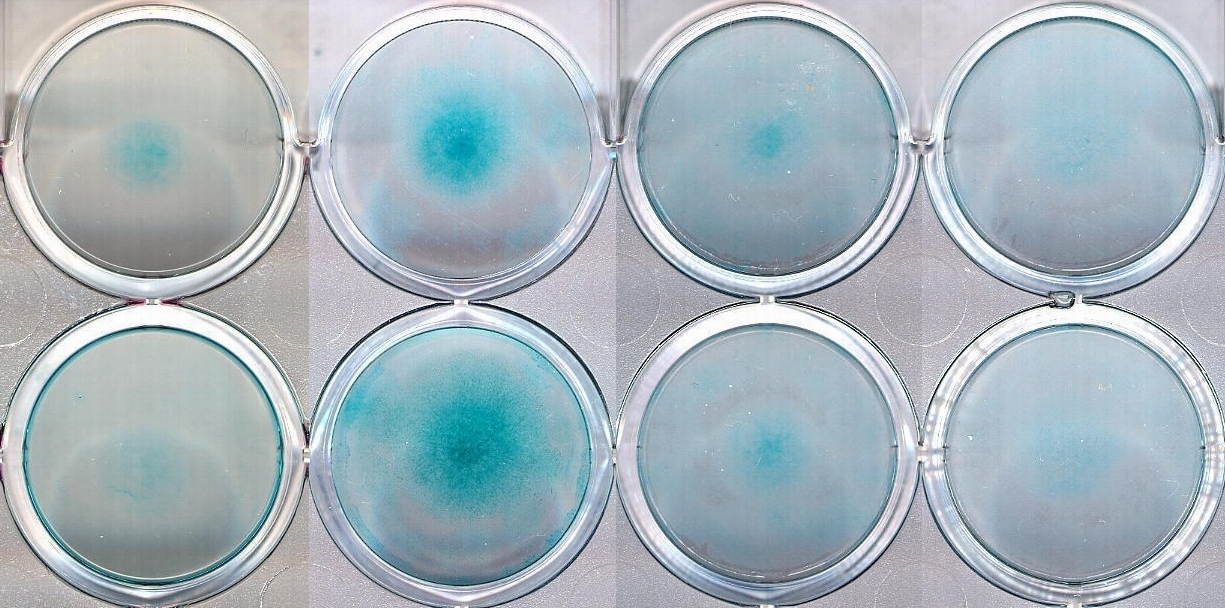

Im Bereich der elektrochemischen Sensoren spielen Elektroden-Blutgassensoren und enzymatische Sensoren (z. B. Glukose) eine besondere Rolle, wobei die Stabilität und Reproduzierbarkeit von Referenzelektroden (Ag/AgCl, seltener Ag/AgBr) Voraussetzungen für eine zuverlässige Voltammetrie und Potentiometrie sind. Die richtige Auswahl der Elektrolytzusammensetzung und die Kontrolle der Alterungsprozesse begrenzen die Drift des Referenzsystems, was sich wiederum auf die Genauigkeit der In-vivo- und In-vitro-Kalibrierung auswirkt.

Die Funktionsweise optischer Sensoren, einschließlich faseroptischer sowie planarer, wellenleiterbasierter Konfigurationen, basiert auf der Strahlungsmodulation durch eine Probe oder einen Indikator. In der Praxis gibt es drei grundlegende Schemata: direkter Einfluss des Analyten auf die Eigenschaften des Wellenleiters (z. B. Refraktometrie unter Verwendung einer Verdunstungswelle oder Plasmonenresonanz), Fernübertragung von Licht zur Probe und zurück (In-situ-Spektrophotometrie) und die Verwendung eines Indikators in einer Polymermatrix an der Vorderseite der optischen Faser. Diese Architekturen ermöglichen den Bau von Oximetern, Gassensoren, Glukosesensoren und Immunosensoren – zunehmend mit Schwerpunkt auf der kontinuierlichen Überwachung, auch in ambulanten Einrichtungen.

Aus der Perspektive der medizinischen Messtechnik stehen sämtliche Sensorfamilien vor einer identischen Herausforderung, denn sie müssen eine Schnittstelle entwickeln, die sowohl biokompatibel als auch elektrisch, optisch und chemisch stabil ist. Der Konstrukteur muss gleichzeitig den Gewebekontakt, die Sterilisierbarkeit, die Widerstandsfähigkeit gegen Umwelteinflüsse, die Ergonomie der Verwendung und die Einschränkungen analoger Spuren in medizinischen Geräten berücksichtigen. Die Kapitel zu Sensoren präsentieren, in Abhängigkeit von der geforderten Auflösung, der Reaktionszeit sowie dem Signal-Rausch-Verhältnis, nicht nur die verschiedenen Wandlerklassen, sondern ebenfalls die systematische Auswahllogik für Lichtquellen, optische Elemente, Detektoren und Signalwege.

Erfassung, Komprimierung und Analyse

Das zweite Glied in der Informationskette umfasst die Signalerfassung, -aufbereitung und -analyse. Biologische Signale sind von Natur aus nicht stationär, signalarm und anfällig für Störungen, sodass die Kenntnis ihrer Herkunft und ihrer spektralen Eigenschaften die Wahl der Verarbeitungsmethoden bestimmt. Das Lehrbuch präsentiert eine klare, systematische Logik: Zunächst erfolgt die Klassifizierung von Biosignalen, gefolgt von den Grundlagen der Frequenzanalyse, anschließend werden Erfassungs- und Filtertechniken behandelt, und abschließend werden spezifische Werkzeuge zur Beschreibung der Zeit-Frequenz-Dynamik, der Nichtlinearität sowie der Komplexität biologischer Systeme umfassend dargestellt.

In der klinischen Praxis sind Lösungen vorherrschend, die adaptive Filter- und Spektrumschätzungsverfahren mit Zeit-Frequenz-Darstellungen kombinieren. Die Kurzzeit-Fourier-Transformation (STFT) ermöglicht die Lokalisierung von Ereignissen sowohl in der Zeit als auch in der Frequenz; ihre Auflösung ist jedoch durch das Unschärfeprinzip begrenzt. Die Anwendung höherdimensionaler Analysemethoden wie Bispektrum und Trisektrum ist dann angezeigt, wenn der Nachweis nichtlinearer Effekte gerechtfertigt erscheint, da diese Verfahren eine klare Differenzierung zwischen durch nichtlineare sowie durch lineare Prozesse generierten Signalen erlauben, was insbesondere bei der Beurteilung der Wechselwirkung biologischer Rhythmen von entscheidender Bedeutung ist. Diese Werkzeuge werden als moderne Toolbox für Biomedizintechniker hervorgehoben.

Angesichts der zunehmenden Bedeutung von Telemetrie und Langzeitüberwachung hat sich Datenkompression von einer bloßen Option zu einer unabdingbaren Notwendigkeit entwickelt. Für Mehrkanalsignale wie das EKG konzipierte domänenspezifische (DCT, FFT), multiresolutionale (Wavelet, Subband) und hybride Algorithmen bewahren die klinische Relevanz, während sie gleichzeitig die Anforderungen an Bandbreite und Speicher minimieren. Es ist erwähnenswert, dass die genauen Mechanismen, die die Komprimierung ermöglichen, auch dazu dienen, Ereignisse zu erkennen und Merkmale in Echtzeit-Streams zu extrahieren.

Die Komplexitätstheorie sowie das maschinelle Lernen inspirieren Werkzeuge, welche klassische Methoden ergänzen. Bei der Analyse sensorimotorischer, kardialer sowie neurologischer Signale implementieren neuronale Netze nichtlineare Abbildungen, welche hochdimensionale, verrauschte Merkmalsvektoren verarbeiten. Fraktale sowie Skalierungsmaße erfassen die Rauheit physiologischer Dynamiken und erweisen sich somit als wertvoll für die Charakterisierung neurodegenerativer Erkrankungen oder Schlafstörungen. Diese Ansätze ersetzen die physiologische Modellierung nicht, sondern etablieren eine zusätzliche Berechnungsebene, welche die Sensitivität sowie Spezifität klinischer Klassifikatoren erhöht.

Es ist hervorzuheben, dass die Wirksamkeit von Verarbeitungsalgorithmen von den Erfassungsbedingungen abhängt. Bewegungsresistenz, Kontaktimpedanzstabilität, geeignete Auswahl der Dynamik von A/C-Wandlern und Anti-Aliasing-Filtern sowie die galvanische Trennung der Spuren vom Patienten sind Randbedingungen. Eine Vernachlässigung dieser Faktoren verursacht systematische Fehler, deren Ausmaß den potenziellen Nutzen selbst der ausgefeiltesten Analyse übersteigt. Dieser Aspekt, der das Design von Sensoren und Erfassungskreisen integriert, wird in dem Abschnitt des Handbuchs behandelt, der sich mit medizinischen Instrumenten befasst, insbesondere mit Biopotentialverstärkern und nicht-invasiven Methoden zur Messung kardiovaskulärer Parameter.

Bildgebung

Die dritte Säule der Informationskette ist die Bildgebung. Das Spektrum der in diesem Lehrbuch behandelten Techniken – von der klassischen Röntgendiagnostik und Angiographie über die Computertomographie (CT), Magnetresonanztomographie (MRT), Nuklearmedizin (SPECT, PET) bis hin zu Ultraschall und Impedanztomographie – schafft eine multimodale Plattform, auf der jede Technik eine andere Projektion des Zustands des Patienten liefert. Zur Beantwortung spezifischer klinischer Fragen werden, in der Logik der Integration, die räumliche Auflösung, der Gewebekontrast sowie die funktionelle Empfindlichkeit kombiniert.

Die Entscheidung bezüglich der Modalität wird gemeinsam durch Ingenieure sowie Kliniker getroffen. Ergibt sich der Untersuchungsfokus auf die Knochenarchitektur sowie die Mineralisierung, so erweisen sich Röntgen- und CT-Verfahren als vorteilhaft. Erfordert hingegen die Beurteilung von Weichteilkontrast, Spektroskopie und funktionellen Parametern eine spezialisierte Methodik, so finden MRT mit fMRT-Varianten sowie die chemische Verschiebungsbildgebung ihre Anwendung. Radiopharmaka und Gammadetektion (SPECT, PET) werden zur Beurteilung der Perfusion und des Stoffwechsels eingesetzt.

Ultraschall ermöglicht dank piezoelektrischer Wandler die Kombination von morphologischer Bildgebung mit hämodynamischen Messungen (Doppler). Die Datenintegration wird manchmal durch Hardware (PET/CT-Hybride) oder Software (Bildregistrierung, Fusion und parametrische Kartierung) erreicht. Modular organisiert, präsentiert das Lehrbuch diese Techniken und unterstreicht explizit, dass sowohl die Rekonstruktionsschicht als auch die Bildverarbeitung den Geräten selbst an Bedeutung in nichts nachstehen.

Es ist anzumerken, dass die Ultraschall-Durchflussmessung, bei der Doppler-Algorithmen den Beschallungswinkel, Geschwindigkeitsaliasing und Abtasteigenschaften berücksichtigen müssen, ein wichtiger Faktor ist. Die vorliegende Problematik veranschaulicht das allgemeine Gesetz der Informationskette, indem die Spezifität des physikalischen Bildgebungsmechanismus die Grenzen der Verarbeitung und Interpretation determiniert. Analog verhält es sich bei tomografischen Rekonstruktionen, wo die Selektion des Algorithmus, beispielsweise FBP gegenüber iterativen Verfahren, das Signal-Rausch-Verhältnis determiniert, sodass die Betriebsparameter des Systems niemals isoliert vom angestrebten klinischen Ziel evaluiert werden dürfen.

Technologiemanagement und Standards

Ohne eine adäquate organisatorische Infrastruktur vermögen selbst ein optimal konzipierter Sensor und ein anspruchsvoller Algorithmus keinen klinischen Nutzen zu generieren. An dieser Stelle kommt die Medizintechnik ins Spiel, eine Disziplin, die sich in den 1960er und 1970er Jahren als Reaktion auf die zunehmende Komplexität der Krankenhaustechnologien und die Notwendigkeit eines systematischen Risikomanagements entwickelt hat. Ein solcher Ingenieur ist ein Spezialist, der an der Kette der Krankenhausprozesse beteiligt ist, von der Technologiebewertung über die Investitionsplanung und das Gerätemanagement bis hin zur Erstellung von Qualitätsindikatoren, Sicherheitsaudits und der Einhaltung von Standards.

Die Entwicklung der klinischen Technik verlief parallel zur Erweiterung der Krankenhausabteilungen, der Standardisierung von elektrischen Sicherheitsinspektionen und der Einführung von TQM/CQI-Methoden für die Geräteüberwachung. Praxiserfahrungen belegen, dass elektrische Störungen lediglich die Spitze des Eisbergs darstellen. Ein ebenso hohes Gefährdungspotenzial geht von betrieblichen Nichtkonformitäten, Kalibrierungsfehlern, unzureichenden Schulungen sowie der Nichtberücksichtigung des Geräte-Lebenszyklus aus. Als Reaktion darauf wurden Risikobewertungsinstrumente, Programmindikatoren und eine Überprüfung der Vorschriften und Normen eingeführt, damit klinische Ingenieure Wartungs- und Schulungsmaßnahmen priorisieren können.

Überprüfungen durch Normungs- und Regulierungsbehörden erlangen in diesem Zusammenhang eine herausgehobene Bedeutung. Obwohl sich bestimmte Normen und Regulierungsstrukturen kontinuierlich weiterentwickeln, bestimmt die Logik der Normenhierarchie den Rahmen, innerhalb dessen Hersteller und Krankenhäuser agieren, der von grundlegenden elektrischen Sicherheitsanforderungen über Vorgaben zur elektromagnetischen Verträglichkeit und produktkategoriespezifische Normen bis hin zu klinischen Bewertungen reicht. Im Einklang damit stehen Methoden zur Berechnung des Geräterisikos und zur Erstellung von Programmindikatoren, die sowohl die Prozesseffizienz als auch die Patientensicherheit widerspiegeln.

Medizinische Instrumente

Der Abschnitt zu medizinischen Instrumenten und Geräten stellt die Signalqualität in den Mittelpunkt und basiert auf realen klinischen Designs. Biopotentialverstärker, Druck- und Durchflussmesssysteme, externe und implantierbare Defibrillatoren, Stimulatoren, Anästhesiegeräte, Beatmungsgeräte und Infusionspumpen – all diese Produktklassen übertragen Anforderungen von der Sensor- und Analyseebene auf die Systemebene: Stromversorgung, Sicherheit, Isolierung, Steuerungsalgorithmen und Mensch-Maschine-Schnittstelle. Die Integration der Fachgebiete Elektronik, Materialwissenschaften, Informatik und Risikomanagement hat den historischen Sprung von einfachen Handwerkzeugen zu komplexen, multimodalen Systemen ermöglicht.

Bei der Entwicklung eines Biopotentialverstärkers geht es nicht allein um die Erhöhung der Verstärkung und die Reduzierung von Rauschen, sondern vielmehr um eine umfassende Optimierung der Verstärkerleistung. Erforderlich sind ein hoher CMRR, eine robuste Unterdrückung von Bewegungsartefakten und Netzwerkstörungen, die Implementierung von Eingangsfiltern ohne Verzerrung des Diagnosebands sowie eine sichere Patientenanbindung. Wenn ein solcher Verstärker Teil eines neuromuskulären Stimulators oder Defibrillators wird, spielen Fragen der Impulsenergiequalität, der Elektrodengeometrie und -materialien, der Synchronisation mit dem Herzrhythmus sowie der Arrhythmieerkennungslogik und der Rückkopplungssensoren eine Rolle. Dieser integrative Ansatz schließt den Kreis zu den früheren Abschnitten des Lehrbuchs.

Themen aus der Zahnmedizin und Materialwissenschaft

Unser Hauptaugenmerk gilt zwar den Sensoren und Signalen, dennoch besteht zwischen der Biomedizintechnik einerseits sowie der Materialwissenschaft und der zahnmedizinischen Behandlungsplanung andererseits eine untrennbare Verbindung. Die Zahnimplantologie ist ein Beispiel dafür, dass Bildgebung (CBCT/CT, MRT in bestimmten Anwendungen, intraorale Ultraschalluntersuchung), Sensoren (Messung der Implantatstabilität und der Okklusionskräfte), Signalanalyse (Heilungsüberwachung) und Materialien (Titanlegierungen, Biokeramik) als einheitliches System behandelt werden müssen.

Die Zuverlässigkeit der Daten wird vom ersten Kontakt des Sensors mit dem Patienten bis zur abschließenden klinischen Validierung sichergestellt, sodass die Entscheidungen über die Eigenschaften der Implantatoberfläche, den Knochenzustand, die Qualität des Implantatbettes sowie die prothetische Belastung auf einer fundierten Informationsbasis beruhen. Die Material- und Sensor-Rahmenwerke im Kompendium unterstützen diesen Ansatz: Die Abschnitte über harte und weiche Biomaterialien sind logisch mit den Abschnitten über Sensorik und Bildgebung verknüpft, wodurch der interdisziplinäre Charakter der Therapiegestaltung betont wird.

Transportphänomene und biomimetische Systeme

fortschrittlichsten Berechnungswerkzeuge ohne eine genaue Beschreibung der Physik des Systems unwirksam sind. Diffusion, Konvektion in der Mikrozirkulation, Wärmeleitfähigkeit und Massenwiderstand in der Arterienwand setzen die Grenzen der Erkennbarkeit und Interpretation sowohl für Signale als auch für Bilder. Im Rahmen dieses Ansatzes werden elektronische Parameter in biologische Größen übersetzt, wozu Permeabilität, Diffusionskoeffizienten sowie Randbedingungen zählen. Diese Theorieebene unterstützt die Entwicklung gezielter Therapien, beispielsweise die Verabreichung von Medikamenten an das Gehirn, und liefert Informationen zu den Messbeschränkungen, die bei der klinischen Validierung berücksichtigt werden müssen.

In der Systempraxis müssen alle beschriebenen Ebenen bei der Validierung zusammenkommen. Die klinische Messtechnik umfasst die Installationsqualifizierung (IQ), die Betriebsqualifizierung (OQ) und die Leistungsqualifizierung (PQ) von Geräten, einschließlich elektrischer Sicherheit, EMV, Genauigkeit, Langzeitstabilität, Umweltbeständigkeit und Übereinstimmung mit den Tests des klinischen Anwendungsprofils. Im Rahmen der Material- und Biokompatibilitätsqualifizierung sind Sensoren zu evaluieren, während Erfassungskanäle einer dynamischen Parameterüberprüfung zu unterziehen sind.

Algorithmen bedürfen einer analytischen sowie klinischen Validierung, welche durch eine Überanpassungskontrolle ergänzt wird, und Bildgebungssysteme erfordern eine geometrische wie photometrische Korrektur. Die klinische Technik organisiert diese Aktivitäten in Zyklen von Überprüfungen und Audits und kombiniert dabei Risikoanalysen mit Dokumentation und Anwenderschulungen, um ein effektives Management zu gewährleisten. Daher stellen die Abschnitte über Normen, Programmindikatoren und Technologiemanagement eine wesentliche Ergänzung zu den technischen Kapiteln dar.

Der wachsende Bereich der ambulanten und häuslichen Pflege ist ein Bereich, in dem die Integration von Sensorik, Konnektivität, Datenkompression und klinischer Technik zu greifbaren Gesundheitsergebnissen führt. Geräte für den Heimgebrauch müssen eine benutzerfreundliche Oberfläche, autonome Sicherheitskontrollmechanismen und Fernübertragungsprotokolle kombinieren, um eine optimale Funktionalität zu gewährleisten.

Zur Gewährleistung der messtechnischen Konsistenz zwischen häuslicher und klinischer Umgebung ist es, aus der Perspektive der Informationskette, von entscheidender Bedeutung, sicherzustellen, dass Entscheidungsalgorithmen ihre Kalibrierung nicht aufgrund differierender Umwelt- und Nutzungsbedingungen verlieren. Es ist anzumerken, dass bei der Konstruktion von Heimgeräten atypische Nutzungsprofile berücksichtigt werden müssen, die die Auswahl von Sensoren, Selbstdiagnosealgorithmen und Alarmrichtlinien beeinflussen.

Datenanalyse und Validierung in der Biomedizintechnik – Zusammenfassung

In der modernen Biomedizintechnik bildet die integrierte Kette, die vom Photon bis zur klinischen Entscheidung reicht, die praktische Architektur. Die Qualität der Informationen an der Quelle wird maßgeblich durch den ersten Abschnitt dieser Kette, die Sensoren, definiert. An der Metall-Elektrolyt-Grenzfläche, in optischen Wellenleitern oder in enzymatischen Transduktionssystemen treten Rauschen, Drifts und Nichtlinearitäten auf, die später ohne Informationskosten durch keinen algorithmischen Trick beseitigt werden können.

Die Signalerfassung und -analyse gibt dieser Informationsstruktur durch adaptive Filterung, Zeit-Frequenz-Darstellungen, Methoden höherer Ordnung, maschinelles Lernen und Komprimierung Struktur – immer unter Berücksichtigung der Physiologie des Signals und der Grenzen des Messpfads. Ein umfassender morphologischer und funktioneller Kontext wird durch die Bildgebung bereitgestellt. Erst die Verknüpfung mit zeitlichen Signalen ermöglicht ein vollständiges Patientenbild. Um messtechnische Präzision in klinische Sicherheit zu überführen, muss all dies in eine klinische Technik eingebettet sein, die Technologiemanagement, Qualitätsindikatoren, Standards und Risikobewertung umfasst.

In der zahnärztlichen sowie der medizinischen Praxis umfasst diese Integration die Implantationsplanung, die Überwachung der Heilung, die Beurteilung der Stabilität sowie der funktionellen Belastung. In der Allgemeinmedizin beinhaltet sie wirksame implantierbare Therapien, Beatmung, Sedierung, Infusionen und Vitalüberwachung, sogar beim Patienten zu Hause. Die übergeordnete Schlussfolgerung ist die Notwendigkeit eines systemischen Designs, das Materialien und Sensoren, Elektronik und Software sowie Organisations- und Schulungsprozesse umfasst. Ohne diese Perspektive ist es schwierig, die tatsächliche Umsetzung von Technologie in klinische Ergebnisse zu diskutieren.

Literaturverzeichnis

Bronzino, J.D. (Hrsg.). The Biomedical Engineering Handbook. Zweite Auflage. CRC Press, Boca Raton, 2000.