Análisis y validación de datos en ingeniería biomédica

Índice

La ingeniería biomédica moderna depende, cada vez más, de cadenas integradas de medición e interpretación en las que los sensores, los canales de adquisición, los algoritmos de procesamiento y los algoritmos de reconstrucción de imágenes se integran en un único sistema. De igual forma, la práctica clínica está cambiando hacia el uso de cadenas integradas de medición e interpretación en las que los sensores, las vías de adquisición, los algoritmos de procesamiento, las técnicas de imagen y los marcos organizativos y normativos de la ingeniería clínica forman un flujo continuo de información. En este artículo, se explica cómo se diseñan los sensores para las aplicaciones médicas, cómo se construyen cadenas fiables de adquisición de señales biológicas, cómo se convierten las imágenes y las señales en información clínica y por qué la gestión tecnológica y la normalización en el entorno hospitalario determinan la seguridad y la eficacia de la terapia.

Sensores

Los sensores biomédicos convierten cantidades mecánicas, eléctricas, ópticas o químicas en una forma eléctrica compatible con los equipos de medición modernos. Su característica común es la transducción, es decir, la conversión de una forma de energía en otra, y la tarea del diseñador es minimizar la distorsión y la interferencia en la interfaz entre la fisiología y la electrónica. La detección biomédica se puede dividir en detección física (por ejemplo, presión, flujo, temperatura, etc.), electroquímica (por ejemplo, pH, pO₂, pCO₂, glucosa, etc.), óptica (por ejemplo, oximetría de pulso, inmunosensores, etc.) y electrodos biopotenciales para señales de EEG, ECG o EMG. Estas clases constituyen la base de los capítulos sobre los sensores que incluye el libro de texto y que hacen hincapié en que una cadena de información eficiente comienza con la interacción correcta del sensor con los tejidos y los fluidos corporales.

Los electrodos biopotenciales, que se utilizan para registrar la actividad bioeléctrica, realizan la transducción en la interfaz metal-electrolito. En esta interfaz, se observa un potencial de semicelda que depende del material del electrodo y de la composición de la solución. La estabilidad y la reversibilidad de las reacciones redox determinan el ruido, la deriva y los artefactos, lo que hace que la selección de materiales (por ejemplo, Ag/AgCl como electrodos de referencia) y el control del entorno iónico sean fundamentales para la fiabilidad de la medición de señales biológicas de baja frecuencia y cambio lento. Estos fenómenos se describen en la literatura electroquímica y se resumen en compendios sobre sensores. Sin embargo, la práctica clínica requiere traducirlos en requisitos de diseño específicos: baja impedancia de contacto, minimización de la polarización, referencias estables y geometría y presión repetibles.

En el campo de los sensores electroquímicos, los sensores de gases en sangre con electrodos y los sensores enzimáticos (por ejemplo, de glucosa) desempeñan un papel especial en el que la estabilidad y la reproducibilidad de los electrodos de referencia (Ag/AgCl, con menos frecuencia Ag/AgBr) son requisitos previos para que la voltamperometría y la potenciometría sean fiables. La selección adecuada de la composición del electrolito y el control de los procesos de envejecimiento limitan la deriva del sistema de referencia, lo que a su vez afecta a la precisión de la calibración in vivo e in vitro.

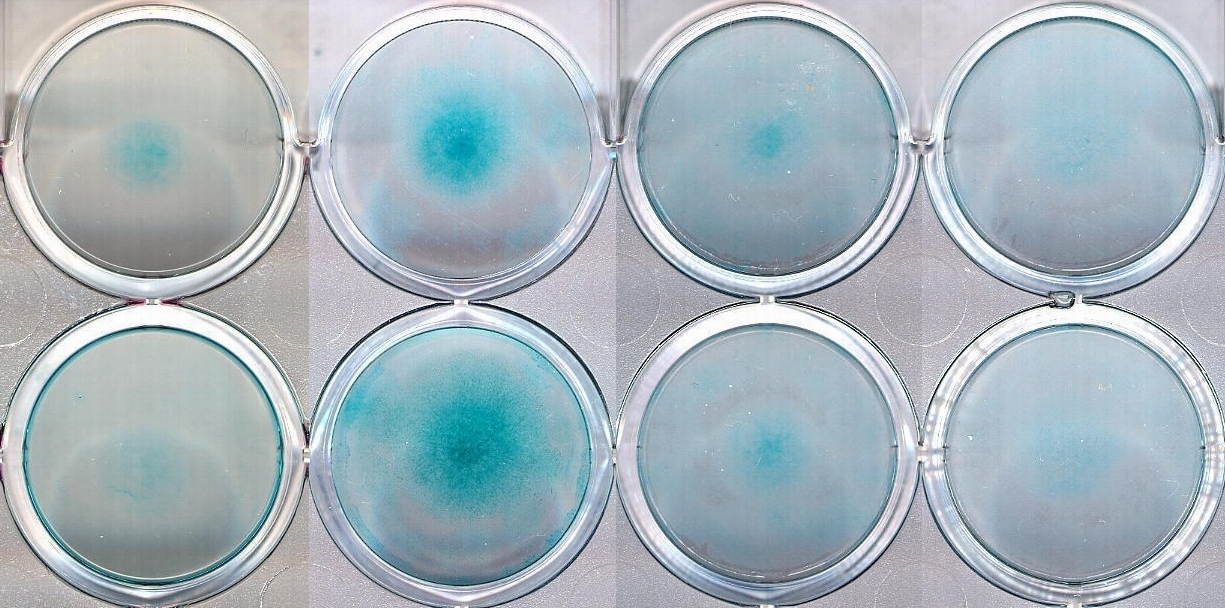

Los sensores ópticos, tanto los basados en la fibra óptica como en las guías de onda planas, utilizan la modulación de la radiación por una muestra o un indicador. En la práctica, existen tres esquemas básicos: influencia directa del analito en las propiedades de la guía de ondas (por ejemplo, refractometría mediante una onda evaporativa o resonancia plasmónica), transporte remoto de la luz a la muestra y viceversa (espectrofotometría in situ) y el uso de un indicador en una matriz polimérica en la parte delantera de la fibra óptica. Estas arquitecturas permiten que se pueda construir oxímetros, sensores de gas, sensores de glucosa e inmunosensores cada vez más centrados en la monitorización continua, incluso en entornos ambulatorios.

Desde la perspectiva de la metrología médica, todas estas familias de sensores comparten un reto común: diseñar una interfaz que sea biocompatible y estable desde el punto de vista eléctrico, óptico y químico. El diseñador debe tener en cuenta, simultáneamente, el contacto con los tejidos, la esterilizabilidad, la resistencia a las interferencias ambientales, la ergonomía de uso y las limitaciones de las pistas analógicas en los dispositivos médicos. Por lo tanto, los capítulos sobre sensores no solo presentan las clases de transductores, sino también la lógica de selección de fuentes de luz, elementos ópticos, detectores y rutas de señal en función de la resolución, el tiempo de respuesta y la relación señal-ruido requeridos.

Adquisición, compresión y análisis

El segundo eslabón de la cadena de información implica la adquisición, el acondicionamiento y el análisis de señales. Las señales biológicas son, intrínsecamente, no estacionarias, de baja intensidad y susceptibles a interferencias, por lo que el conocimiento de su origen y características espectrales determina la elección de los métodos de procesamiento. En términos del libro de texto, la lógica es clara y va desde la clasificación de las señales biológicas y los fundamentos del análisis de frecuencia, pasando por las técnicas de adquisición y filtrado, hasta las herramientas específicas que describen la dinámica tiempo-frecuencia, la no linealidad y la complejidad de los sistemas biológicos.

En la práctica clínica, prevalecen las soluciones que combinan los métodos de filtrado adaptativo y estimación del espectro con las representaciones tiempo-frecuencia. La transformada de Fourier de tiempo corto (STFT) permite localizar eventos tanto en el tiempo como en la frecuencia. Sin embargo, su resolución está limitada por el principio de incertidumbre. Cuando se justifica la búsqueda de no linealidad, el análisis de orden superior (bispectro, trispectro…) permite distinguir entre las señales generadas por procesos no lineales y las generadas por procesos lineales, lo cual es crucial a la hora de evaluar la interacción de los ritmos biológicos. Estas herramientas destacan como una caja de herramientas moderna para los ingenieros biomédicos.

El papel cada vez más importante de la telemetría y la monitorización a largo plazo significa que la compresión de los datos ya no es una opción, sino una necesidad. Los algoritmos específicos de dominio (DCT, FFT, etc.), multirresolución (ondículas, subbandas, etc.) e híbridos para señales multicanal, como el ECG, están diseñados para preservar la relevancia clínica y minimizar, al mismo tiempo, los requisitos de ancho de banda y memoria. Cabe señalar que los mecanismos exactos que facilitan la compresión también sirven para detectar eventos y extraer características en flujos en tiempo real.

Los métodos clásicos se complementan con herramientas inspiradas en la teoría de la complejidad y el aprendizaje automático. Las redes neuronales en el análisis de señales sensoriomotoras, cardíacas y neurológicas introducen mapeos no lineales que pueden manejar vectores de características ruidosos y de alta dimensión. A su vez, las medidas fractales y de escala describen la rugosidad de la dinámica fisiológica, lo que ayuda a caracterizar las enfermedades neurodegenerativas o los trastornos del sueño. Así pues, este conjunto de métodos no sustituye al modelado fisiológico, sino que crea una capa computacional que aumenta la sensibilidad y la especificidad de los clasificadores clínicos.

Cabe destacar que la eficacia de los algoritmos de procesamiento depende de las condiciones de adquisición. La resistencia al movimiento, la estabilidad de la impedancia de contacto, la selección adecuada de la dinámica del convertidor A/C y los filtros antialiasing, y la separación galvánica de las pistas del paciente son condiciones límite. Descuidarlas da lugar a un error sistemático mayor que la ganancia obtenida con el análisis más sofisticado. Este aspecto, que integra el diseño de sensores y circuitos de adquisición, se analiza en la sección del manual dedicada a los instrumentos médicos, en particular, los amplificadores de biopotencial y los métodos no invasivos para medir los parámetros cardiovasculares.

Imagen

El tercer pilar de la cadena de información es la imagen. El espectro de técnicas que se tratan en el libro de texto, desde el clásico diagnóstico por rayos X y la angiografía, pasando por la tomografía computarizada (TC), la resonancia magnética (RM), la medicina nuclear (SPECT, PET), hasta la ecografía y la tomografía por impedancia, crea una plataforma multimodal en la que cada técnica proporciona una proyección diferente del estado del paciente. La lógica de la integración consiste en combinar la resolución espacial, el contraste de los tejidos y la sensibilidad funcional para abordar la cuestión clínica específica.

La elección de la modalidad es una decisión que toman tanto los ingenieros como los médicos. Si la cuestión se refiere a la arquitectura ósea y la mineralización, las técnicas de rayos X y TC ofrecen ventajas. Cuando el contraste de los tejidos blandos, la espectroscopia y la funcionalidad son importantes, se utiliza la RM con variantes de RMf y la imagen de desplazamiento químico. Los radiofármacos y la detección de rayos gamma (SPECT, PET) se utilizan para evaluar la perfusión y el metabolismo. El ultrasonido, gracias a los transductores piezoeléctricos, permite combinar las imágenes morfológicas con las mediciones hemodinámicas (Doppler). La integración de datos se logra, a veces, mediante hardware (híbridos PET/TC) o software (registro de imágenes, fusión y mapeo paramétrico). El libro de texto organiza estas técnicas de forma modular y hace hincapié en que la capa de reconstrucción y el procesamiento de imágenes son tan importantes como el propio equipo.

Cabe señalar que la medición del flujo por ultrasonidos, en la que los algoritmos Doppler deben tener en cuenta el ángulo de insonación, el aliasing de velocidad y las características de muestreo, es un factor clave. Este problema ilustra la ley general de la cadena de información: la especificidad del mecanismo físico de obtención de imágenes determina las limitaciones del procesamiento y la interpretación. Una relación similar se aplica a las reconstrucciones tomográficas: la elección del algoritmo (por ejemplo, FBP frente a métodos iterativos) afecta a la relación ruido-detalle, por lo que los parámetros de funcionamiento del sistema no pueden considerarse aisladamente del objetivo clínico.

Gestión tecnológica y normas

Ni siquiera el sensor mejor diseñado y el algoritmo más sofisticado se traducirán en valor clínico sin la infraestructura organizativa adecuada. Aquí es donde entra en juego la ingeniería clínica, una disciplina que se ha desarrollado desde los años sesenta y setenta en respuesta a la creciente complejidad de las tecnologías hospitalarias y a la necesidad de contar con una gestión sistemática de los riesgos. Este tipo de ingeniero es un especialista que participa en la cadena de procesos hospitalarios, desde la evaluación tecnológica hasta la planificación de inversiones y la gestión de equipos, pasando por la creación de indicadores de calidad, auditorías de seguridad y el cumplimiento de las normas.

La evolución de la ingeniería clínica ha ido en paralelo a la expansión de los departamentos hospitalarios, la estandarización de las inspecciones de seguridad eléctrica y la implementación de métodos TQM/CQI para la supervisión de equipos. La práctica ha demostrado que los fallos eléctricos eran solo la punta del iceberg: las no conformidades operativas, los errores de calibración, la falta de formación y la falta de consideración del ciclo de vida de los equipos eran igualmente peligrosas. En respuesta a ello, se introdujeron herramientas de evaluación de riesgos, indicadores de programas y una revisión de las normativas y estándares para permitir a los ingenieros clínicos priorizar las actividades de mantenimiento y formación.

En este contexto, las revisiones de las agencias normativas y reguladoras son importantes. Aunque los conjuntos específicos de normas y estructuras reguladoras están evolucionando, la propia lógica de la jerarquía de normas (desde los requisitos básicos de seguridad eléctrica hasta los requisitos de compatibilidad electromagnética y las normas específicas de cada categoría de productos y, en última instancia, las evaluaciones clínicas) establece el mapa del terreno por el que se mueven los fabricantes y los hospitales. En consonancia con ello, existen métodos para calcular el riesgo de los dispositivos y crear indicadores de programas que reflejen tanto la eficiencia de los procesos como la seguridad de los pacientes.

Instrumentos médicos

La sección de instrumentos y dispositivos médicos se centra en la calidad de la señal y utiliza diseños clínicos del mundo real. Amplificadores de biopotencial, sistemas de medición de presión y flujo, desfibriladores externos e implantables, estimuladores, dispositivos de anestesia, ventiladores y bombas de infusión: todas estas clases de productos transfieren los requisitos de la capa de detección y análisis a la capa del sistema. Es decir, suministro de energía, seguridad, aislamiento, algoritmos de control e interfaz hombre-máquina. El salto histórico de las herramientas manuales a los complejos sistemas multimodales fue posible gracias a la integración de la electrónica, la ciencia de los materiales, la informática y la gestión de riesgos.

Por ejemplo, el diseño de un amplificador de biopotencial no se limita a aumentar la ganancia y reducir el ruido, sino que también implica optimizar el rendimiento del amplificador. Es necesario garantizar un alto CMRR, resistencia a los artefactos de movimiento y a las interferencias de la red, así como la implementación de filtros de entrada sin distorsionar la banda de diagnóstico y un acoplamiento seguro con el paciente. Cuando un amplificador de este tipo forma parte de un estimulador neuromuscular o un desfibrilador, entran en juego cuestiones como la calidad de la energía del pulso, la geometría y los materiales de los electrodos, la sincronización con el ritmo cardíaco, así como la lógica de detección de arritmias y los sensores de retroalimentación. Este enfoque integrador cierra el círculo con las secciones anteriores del libro de texto.

Temas de odontología y ciencia de los materiales

Aunque nuestro enfoque principal son los sensores y las señales, la ingeniería biomédica está indisolublemente ligada a la ciencia de los materiales y a la planificación de tratamientos dentales. La implantología dental es un ejemplo en el que las imágenes (CBCT/CT, MRI en aplicaciones específicas, US intraoral), los sensores (medición de la estabilidad del implante y las fuerzas oclusales), el análisis de señales (monitorización de la cicatrización) y los materiales (aleaciones de titanio, biocerámicas, etc.) deben tratarse como un sistema unificado. Las decisiones sobre las características de la superficie del implante, el estado del hueso, la calidad del lecho y la carga protésica se basan en datos cuya fiabilidad se construye desde el primer contacto del sensor con el paciente hasta la validación clínica final. Los marcos de materiales y sensores del compendio respaldan este enfoque: las secciones sobre biomateriales duros y blandos están lógicamente vinculadas a las secciones sobre detección e imagen, lo que enfatiza la naturaleza interdisciplinaria del diseño de la terapia.

Fenómenos de transporte y sistemas biomiméticos

Los capítulos sobre los fenómenos de transporte y los sistemas biomiméticos demuestran que incluso las herramientas computacionales más avanzadas son ineficaces sin una descripción precisa de la física del sistema. La difusión, la convección en la microcirculación, la conductividad térmica y la resistencia de masa en la pared arterial establecen los límites de detectabilidad e interpretación tanto de las señales como de las imágenes. Aquí es donde traducimos los parámetros electrónicos a parámetros biológicos, lo que incluye la permeabilidad, los coeficientes de difusión y las condiciones de contorno. Esta capa de teoría respalda el diseño de terapias específicas (por ejemplo, la administración de fármacos al cerebro) y también informa sobre las limitaciones de medición que deben tenerse en cuenta durante la validación clínica.

En la práctica del sistema, todas las capas descritas deben converger en la validación. La metrología clínica incluye la calificación de la instalación (IQ), la calificación operativa (OQ) y la calificación del rendimiento (PQ) de los dispositivos, incluyendo la seguridad eléctrica, la compatibilidad electromagnética (EMC), la precisión, la estabilidad a largo plazo, la resistencia ambiental y el cumplimiento de las pruebas del perfil de aplicación clínica. Los sensores deben someterse a una calificación de materiales y biocompatibilidad, los canales de adquisición deben someterse a una verificación de parámetros dinámicos, los algoritmos deben someterse a una validación analítica y clínica con control de sobreajuste y los sistemas de imagen deben someterse a una corrección geométrica y fotométrica. La ingeniería clínica organiza estas actividades en ciclos de revisiones y auditorías, y combina el análisis de riesgos con la documentación y la formación de los usuarios para garantizar una gestión eficaz. Por eso, en la estructura del manual, las secciones sobre normas, indicadores de programas y gestión tecnológica son un complemento esencial para los capítulos técnicos.

El creciente campo de la atención ambulatoria y domiciliaria es uno en el que la integración de la detección, la conectividad, la compresión de datos y la ingeniería clínica se traduce en resultados tangibles para la salud. Los dispositivos de uso doméstico deben combinar una interfaz fácil de usar, mecanismos de control de seguridad autónomos y protocolos de transmisión remota para garantizar una funcionalidad óptima. Desde la perspectiva de la cadena de información, es fundamental garantizar la coherencia metrológica entre el entorno doméstico y el hospitalario, de modo que los algoritmos de toma de decisiones no pierdan su calibración debido a las diferencias ambientales y de uso. Cabe señalar que el diseño de los equipos domésticos requiere tener en cuenta perfiles de uso atípicos que influyen en la selección de sensores, algoritmos de autodiagnóstico y políticas de alarma.

Análisis y validación de datos en ingeniería biomédica: resumen

La cadena integrada desde el fotón hasta la decisión clínica es la arquitectura práctica de la ingeniería biomédica moderna. Su primer segmento, los sensores, determina la calidad de la información en la fuente. En la interfaz metal-electrolito, en las guías de onda ópticas o en los sistemas de transducción enzimática, están presentes el ruido, las desviaciones y las no linealidades que ningún algoritmo mágico puede eliminar posteriormente sin costes de información.

La adquisición y el análisis de señales proporcionan esta estructura de información mediante el filtrado adaptativo, las representaciones de tiempo-frecuencia, los métodos de orden superior, el aprendizaje automático y la compresión, y respetan siempre la fisiología de la señal y las limitaciones de la ruta de medición. Las imágenes proporcionan un rico contexto morfológico y funcional que, cuando se fusiona con señales temporales, crea una imagen más completa del paciente. El conjunto debe integrarse en la ingeniería clínica, que abarca la gestión de la tecnología, los indicadores de calidad, las normas y la evaluación de riesgos, ya que solo así la precisión metrológica se traduce en seguridad clínica.

En la práctica dental y médica, esta integración se traduce en la planificación de implantes, la supervisión de la cicatrización, la evaluación de la estabilidad y la carga funcional y, en medicina general, en terapias implantables eficaces, ventilación, sedación, infusiones y monitorización vital, incluso en el domicilio del paciente. La conclusión principal es la necesidad de un diseño sistémico, que abarque materiales y sensores, electrónica y software, así como procesos organizativos y de formación. Sin esta perspectiva, resulta difícil debatir la traducción real de la tecnología en resultados clínicos.

Bibliografía

Bronzino, J. D. (ed.). The Biomedical Engineering Handbook. Segunda edición. CRC Press, Boca Ratón, 2000.